簡介

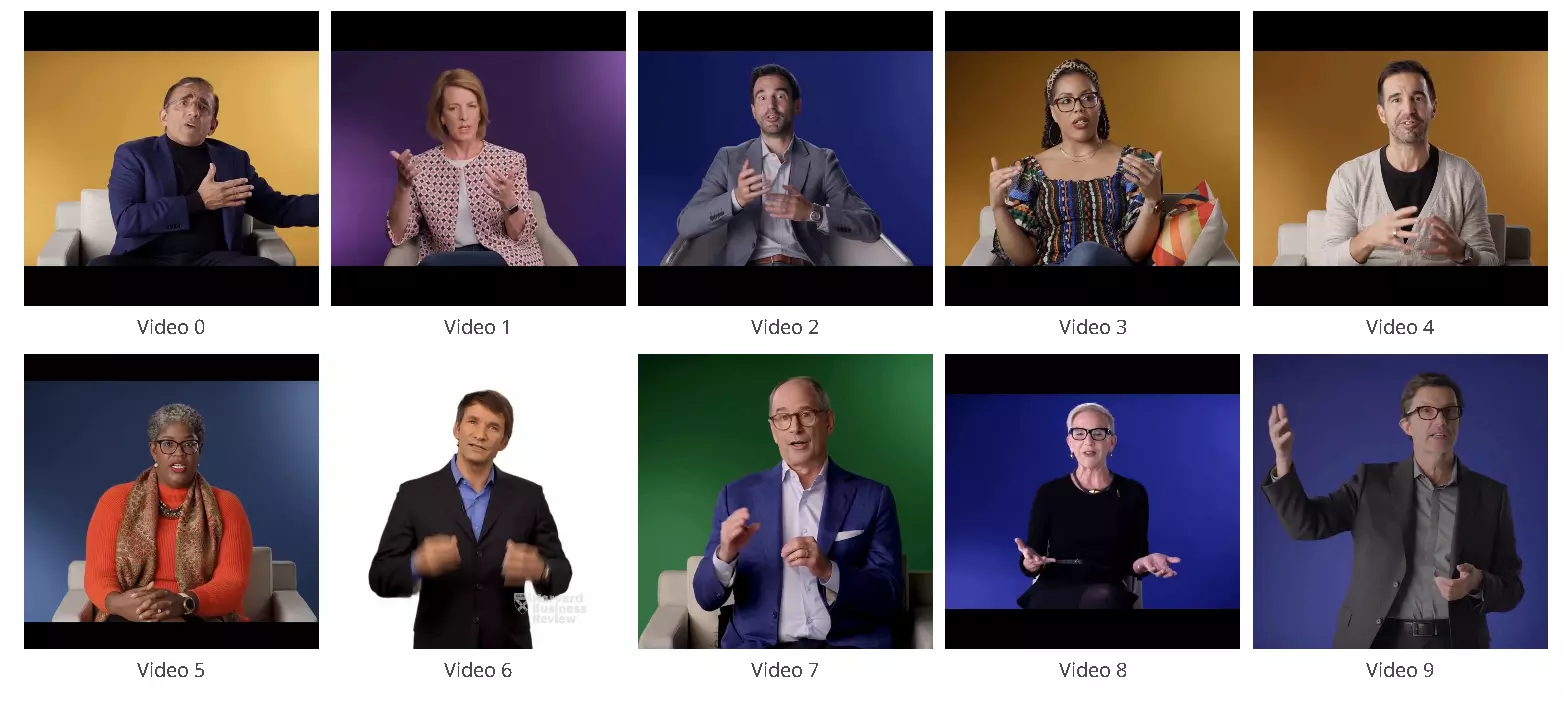

想像一下,您只需一段影片和音頻,便能生成與之完美同步的虛擬人影像。不論是新聞播報、虛擬主播,還是教育內容,TANGO都能助您輕鬆實現。這項開源技術正引領數位內容創作的未來。

打破傳統的數位分身限制

TANGO結合尖端的圖形檢索技術與擴散模型技術,提供自然流暢的身體動作生成,讓音頻與影像無縫銜接,並徹底消除過去生成模型中常見的畫面失真與動作失調問題。

TANGO的三大創新突破

階層式音頻-動作嵌入空間

- 透過AuMoCLIP技術,TANGO首次實現音頻與動作的深度聯繫。不論是語速、語調還是手勢特徵,都能被精準捕捉,實現跨模態的完美同步。

外觀一致性的擴散插補模型

- 全新ACInterp技術,在動畫生成過程中加入背景與動作參考模塊,確保每一幀畫面都保持自然流暢且與原始風格一致。

高效的動作圖構建與優化

- 利用圖修剪技術,TANGO在無限長度的影片生成中避免動作跳躍與不連續,讓每個過渡動作天衣無縫。

應用場景

- 虛擬主播:打造生動自然的虛擬人進行實時互動或節目主持。

- 教育內容:快速生成與教學語音同步的動畫講師,提高課程吸引力。

- 企業展示:生成專業的商業簡報或產品介紹影片,降低製作成本。

效果對比

在目前公開數據集上,TANGO展現出卓越的性能:

- 視覺質量得分提升33.8%,幾乎可與真實影片媲美。

- 動作與音頻的同步性達到前所未有的高度,超越傳統生成方法(如GAN和關鍵字匹配)。

體驗TANGO的魔力

若是不用HeyGen,可以試試TANGO不僅是開源技術的巔峰,更是未來數位內容創作的希望。

讓您的創作邊界再無限制,TANGO與您共同邁向數位內容創新的未來!

其他連結

DMflow.chat

探索DMflow.chat,立即開啟AI驅動的客戶服務新時代。

Learn More

videoweaver.app

Video Weaver: 瀏覽器內完成專業影片剪輯,無需下載、即刻創作。

Learn More

DMflow.chat

DMflow.chat: 您的智能AI夥伴,提升客戶互動、創造卓越體驗。

Learn More

DMflow.chat

探索DMflow.chat,立即開啟AI驅動的客戶服務新時代。

Learn More

videoweaver.app

Video Weaver: 瀏覽器內完成專業影片剪輯,無需下載、即刻創作。

Learn More

DMflow.chat

DMflow.chat: 您的智能AI夥伴,提升客戶互動、創造卓越體驗。

Learn MoreRecommended for You

LongCat-Video 登場:美團發表統一影片生成模型,挑戰分鐘級影片極限

探索美團最新發表的AI影片生成模型 LongCat-Video。它不僅是一個統一框架,能處理文生影片、圖生影片等多種任務,更擅長生成長達數分鐘的高品質影片,向「世界模型」邁出重要一步。 AI 影片生成的賽道最近真的越來越熱鬧了。當我們還在驚嘆於 OpenAI Sora 或快手 Kling 所展示的驚人效果時,另一位重量級選手也帶著獨特的技術加入了這場競賽。 那就是由美團(Meituan)團隊發表的 LongCat-Video,一個統一的基礎影片生成模型。 你可能會想,又是一個 AI 影片工具?有什麼特別的嗎?老實說,它的確有幾個非常吸引人的亮點,特別是在解決目前 AI 影片生成的一些核心痛點上。 不只是單一功能,這是一個「全能型」的統一模型 許多 AI 模型專注於單一任務,例如「文字轉影片」或「圖片轉影片」。但 LongCat-Video 走的是一條更整合的路線。它採用了統一的架構,將多種主流的影片生成任務整合在一個模型中。 這意味著,無論你是想: Text-to-Video: 輸入一段文字描述,生成對應的影片。 Image-to-Video: 給定一張靜態圖片,讓它動起來。 Video-Continuation: 延續一段現有的影片,生成後續的內容。 LongCat-Video 都能用同一個核心模型來處理。這就像擁有一個影片創作的瑞士軍刀,而不是一堆單獨的工具,大大簡化了工作流程。 真正的亮點:高效生成「分鐘級」長影片 這可能是 LongCat-Video 最令人興奮的特色。 如果你玩過其他的 AI 影片工具,你可能會發現,生成幾秒鐘的短片很容易,但要製作一段長達數分鐘、內容連貫且畫質穩定的影片,卻是個巨大的挑戰。很多模型在時間拉長後,會出現畫面風格丕變、顏色漂移(color drifting),或是角色前後不一的窘境,就像一個講故事講到一半忘了主角長相的說書人。 LongCat-Video 巧妙地解決了這個問題。它的秘密武器在於,模型在預訓練階段就專注於「影片續寫(Video-Continuation)」任務。換句話說,它從一開始就被訓練成一個「故事接龍」的高手。 這種原生的續寫能力,讓它在生成長影片時,能更好地保持內容的連貫性和品質穩定性,避免了畫面崩壞或風格錯亂的問題。根據官方展示,它能夠產出長達數分鐘的影片而沒有明顯的品質下降。 它是如何做到的?一窺背後的技術魔法 聽起來很神奇,對吧?LongCat-Video 的高效與高品質,主要歸功於幾個關鍵技術的結合: 由粗到精(Coarse-to-Fine)的生成方式: 這個方法很直觀,就像畫家畫畫一樣,先打個草稿,再逐步完善細節。模型會先生成一個低解析度的影片雛形,然後再逐步提升解析度和細節,最終產出 720p、30fps 的高畫質影片。這不僅提升了效率,也確保了最終的品質。 區塊稀疏注意力(Block Sparse Attention): 這是為了提升運算效率的聰明設計。傳統的注意力機制會讓 AI 一次處理畫面的所有資訊,非常耗費資源。而區塊稀疏注意力則讓 AI 能「專注」在畫面上最重要的部分,跳過不相關的區域,既聰明又省力,大大加快了生成速度。 多獎勵強化學習(Multi-Reward RLHF): 你可能聽過 RLHF(人類回饋強化學習),也就是讓模型從人類的偏好中學習。LongCat-Video 更進一步,採用了「多獎勵」機制。這代表它不只學習「像不像」,而是從多個維度去評斷影片的好壞,例如:畫面美感、動作流暢度、故事邏輯、與文字描述的貼合度等。這讓最終產出的影片更符合人類的審美和期待。 不只是生成,還能「互動」的影片創作 LongCat-Video 還展示了一項非常有趣的功能:互動式影片生成。 這代表使用者可以像導演一樣,在影片生成的過程中介入並給予新的指令。例如,你可以先生成「一個女孩在廚房切麵包」的場景,接著在影片續寫時,輸入新的指令「她倒了一杯牛奶」,模型就會無縫接軌地生成下一個動作。 這種能力讓創作者不再只是被動的接收者,而是可以主動引導故事走向的參與者,為影片創作帶來了前所未有的自由度和想像空間。 想要親自試試或深入了解嗎? 美團團隊非常大方地將 LongCat-Video 的相關資源開源,讓所有人都能接觸到這項技術。

字節跳動:Video-As-Prompt 模型開源,影片當指令,讓靜態圖秒變動畫!

AI 影片生成領域迎來全新突破!字節跳動(ByteDance)正式開源其創新的 Video-As-Prompt (VAP) 模型。這項技術允許使用者直接用一段參考影片作為「提示」,就能讓任何靜態圖片動起來,並且完美複製參考影片的語義和動態風格。本文將深入解析 VAP 的核心理念、兩種模型的差異,以及它為何能在效能上媲美 Kling、Vidu 等頂尖商業模型。 AI 影片生成的新玩法:不再只是文字遊戲 你是否曾想過,如果能讓一張靜態的照片,像某個影片裡的主角一樣跳舞、奔跑,甚至做出各種細膩的表情,那該有多酷?過去,我們習慣用文字(Text-to-Video)來指揮 AI 生成影片,但文字描述往往難以精準傳達我們腦海中複雜的動態和情感。 現在,這一切都將改變。 字節跳動(ByteDance)最近開源了一項名為 Video-As-Prompt (VAP) 的全新技術,徹底顛覆了傳統的影片生成模式。它的核心概念非常直觀:直接拿一段影片當作指令,去驅動一張靜態圖片。 這就像你指著一段麥可·傑克森的舞蹈影片,然後對一張蒙娜麗莎的畫像說:「嘿,讓她像這樣跳舞!」VAP 就能理解舞蹈的「語義」——不僅僅是動作軌跡,還包括節奏、風格和力量感——並將其應用到蒙娜麗莎的身上。 Video-As-Prompt 的核心理念是什麼? 簡單來說,VAP 的任務是:給定一段帶有特定語義的參考影片(Video Prompt),它能讓一張參考圖片(Reference Image)以和參考影片完全相同的語義動起來。 這背後是一種名為「情境生成」(in-context generation)的全新範式。它不再需要複雜的文字描述或多個條件控制,而是直接從範例影片中學習,理解其中的動態精髓,然後進行模仿和遷移。這使得影片生成變得前所未有的直觀和靈活。 兩種模型,兩種選擇:Wan2.1 vs. CogVideoX 為了滿足不同使用者的需求,字節跳動貼心地提供了 VAP 的兩種版本,它們在能力和穩定性之間做出了不同的取捨。

AI 影片生成迎來「即時」革命?Krea Realtime 模型登場,但通往未來的門票並非人人可得

AI 影片生成技術又有新突破!Krea AI 推出了名為 Krea Realtime 14B 的即時文字轉影片模型。它驚人的運算速度,預示著一個內容創作新時代的來臨,但其背後近乎苛刻的硬體需求,也為這項技術的普及設置了一道高牆。 AI 影片生成,真的能「即時」了嗎? 想像一下,當你打下一段文字,一個生動的影片畫面就即時呈現在眼前,不再需要漫長的等待和渲染。這聽起來像是科幻電影的情節,但隨著 Krea AI 最新發布的 Krea Realtime 14B 模型,這個未來似乎離我們越來越近了。 過去,從文字生成影片(Text-to-Video)雖然令人驚豔,但最大的瓶頸往往在於「時間」。一個幾秒鐘的短片,可能需要花費數分鐘甚至更久的時間來生成,這大大限制了它的應用場景。不過,Krea 這次似乎找到了突破口,直接將「即時」(Realtime)這個詞寫進了模型的名字裡。 核心技術:Self-Forcing 是什麼魔法? 那麼,Krea 是如何實現這種高速生成的呢?答案藏在一項名為「Self-Forcing」的技術裡。 簡單來說,Krea Realtime 14B 模型是從一個更大型的影片模型 Wan 2.1 14B 中「提煉」出來的。傳統的影片擴散模型(video diffusion models)在生成影片時,需要一步一步地去雜訊、計算,過程相對繁瑣。而 Self-Forcing 技術,則巧妙地將這種模型轉化為一種「自回歸模型」(autoregressive model)。 打個比方,這就像是讓模型學會了「自我接龍」。它在生成下一幀畫面時,會參考剛剛生成好的前一幀畫面,而不是每次都從頭開始思考。這種方式大幅簡化了運算流程,讓影片能夠一幀接一幀地快速生成,從而實現了近乎即時的效果。 速度有多快?數字會說話 根據 Krea 官方公佈的資料,Krea Realtime 14B 模型在單張 NVIDIA B200 GPU 上,僅需 4 個推論步驟(inference steps),就能達到 每秒 11 幀(11fps) 的驚人速度。 每秒 11 幀是什麼概念?雖然還不到電影(24fps)或一般影片(30fps)的流暢度,但這個速度已經足以提供即時的視覺回饋,讓創作者可以快速預覽和調整想法。這對於互動娛樂、直播特效或是創意發想等領域來說,無疑是一次巨大的革新。 通往即時的門票:一道可遇不可求的硬體高牆 看到這裡,相信許多人都已經摩拳擦掌,準備親身體驗這項技術了。但先別急,要驅動這頭效能猛獸,所需的「燃料」可非同小可。實現這一切的關鍵,正是當今算力金字塔頂端的硬體——NVIDIA B200 GPU。 這款晶片是專為大規模資料中心和頂級 AI 研究而設計的專業級設備,其運算能力固然令人嚮往,但也意味著它並非尋常的消費級顯卡。可以說,這驚人速度的背後,是一道普通玩家和創作者難以跨越的硬體門檻。這種尖端配置,在目前市場上確實是「可遇而不可求」的存在。 這背後的現實是,儘管 AI 技術的發展日新月異,但尖端技術的普及,往往需要等待硬體生態的成熟與跟進,才能真正從實驗室走向大眾。 即時影片生成的未來想像 儘管硬體門檻如此之高,但 Krea Realtime 14B 的問世,依然為我們揭示了 AI 內容創作的無限可能: