2025-10-30 AI日报 Cursor 2.0 与自研模型 Composer 正面对决 Cognition,Sora 限时免邀请码,AI 竟能「内省」?

2025 年 10 月 29 日(为何是 10 月 29 日,因为日报都是介绍昨日的),AI 领域迎来了惊人的爆发。AI 代码编辑器 Cursor 推出 2.0 版本及自研模型,Cognition AI 则以极速 Agent 模型应战。同时,OpenAI 的 Sora 开放了部分地区的免邀请注册,Google 为开发者送上多重好礼,而 Anthropic 的研究更揭示了 AI 模型可能具备初步的「内省」能力。

今天的 AI 界真是热闹非凡!从开发者工具的重大升级,到视频生成模型的全面开放,再到关于 AI 自我意识的惊人研究,各大巨头和新创公司都在加速奔跑,竞争的火药味也越来越浓。

让我们来快速盘点一下今天有哪些不容错过的重磅消息。

不只是编辑器,Cursor 2.0 打造 AI 开发新范式

AI 优先的代码编辑器 Cursor 今天正式发布了其里程碑式的 Cursor 2.0 版本,带来了全新的 Agent 界面和一个令人惊喜的「杀手锏」:他们的第一款自研代理编码模型——Composer。

根据 官方博客 的介绍,Composer 是一个前沿模型,其最大亮点在于速度——比同等智慧水准的模型快上 4 倍。这意味着开发者可以获得更即时的回应,大幅提升工作效率。

除了强大的内核,Cursor 2.0 的界面也进行了彻底革新。全新的「Multi-Agents」界面允许使用者在单一提示下,最多并行运行八个 Agent。这项功能利用 git worktrees 或远程机器来避免文件冲突,让每个 Agent 都在独立的代码库副本中工作。想像一下,你可以同时让多个 AI 助手分头处理不同任务,或用不同模型解决同一个问题,然后挑选最佳方案,这简直是开发者的梦想。

此外,更新日志 还列出了多项改进,包括:

- 改进的代码审查:跨多个文件的变更一目了然。

- 沙盒终端 (GA):在 macOS 上默认启用,提升安全性。

- 团队指令与语音模式:让团队协作和人机互动更加流畅。

速度之王登场!Cognition 发布 SWE-1.5 极速 Agent 模型

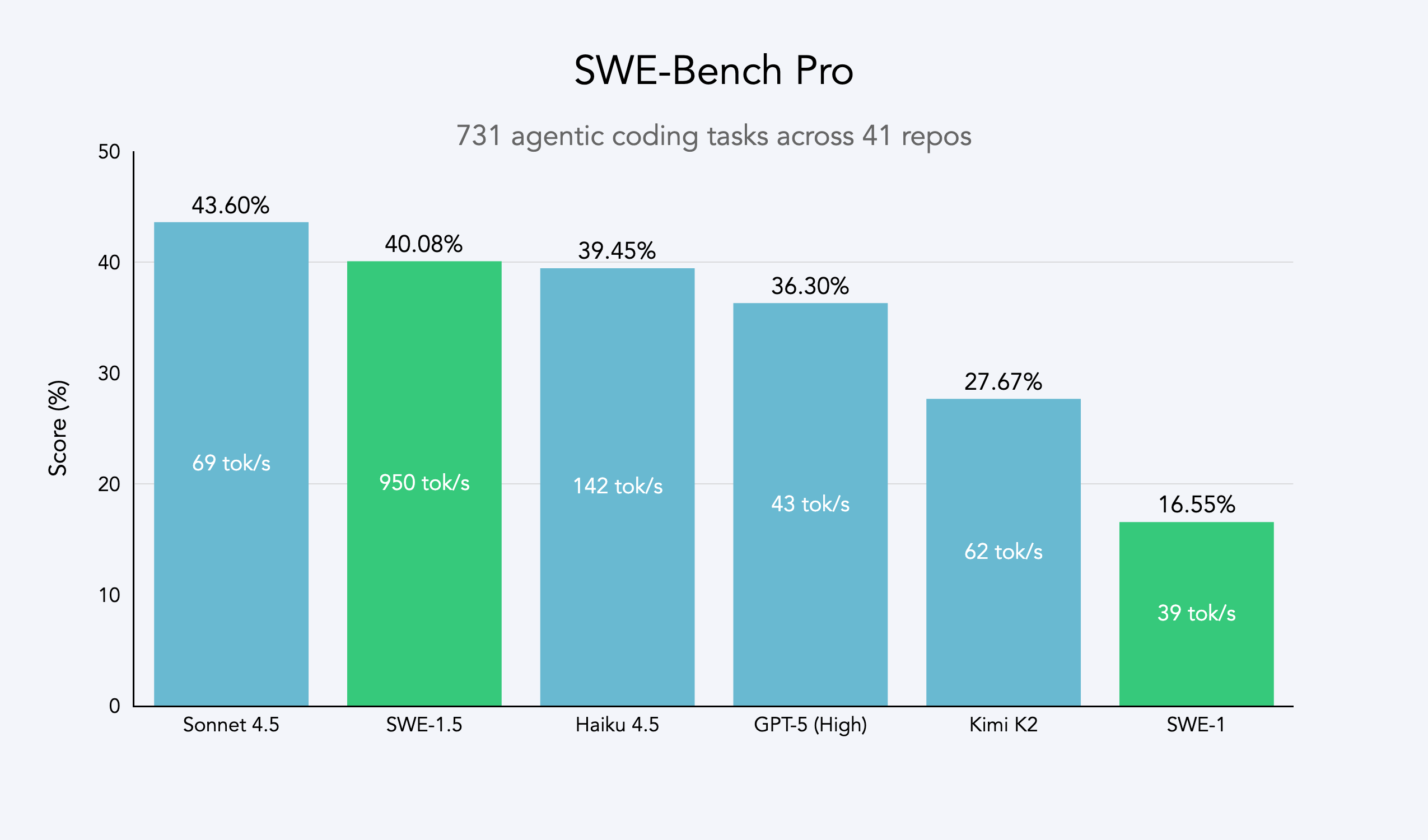

就在 Cursor 推出 Composer 的同时,以 AI 工程师 Devin 闻名的 Cognition AI 似乎也闻到了挑战的气味,迅速推出了他们最新的软件工程模型 SWE-1.5。

如果说 Cursor 的 Composer 强调的是综合体验,那么 SWE-1.5 的核心卖点就是一个字:快。

Cognition 与 Cerebras 合作,让 SWE-1.5 的运行速度达到了惊人的 950 tok/s,这比 Haiku 4.5 快 6 倍,比 Sonnet 4.5 快 13 倍。这种速度让许多过去需要数十秒的任务,现在能在 5 秒内完成。这场 AI 代码助理的竞争,显然已经进入了「速度与激情」的阶段。SWE-1.5 目前已在 Windsurf 平台上线。

Sora 视频生成自由玩!美加日韩限时免邀请码

对于内容创作者来说,今天最大的好消息莫过于 OpenAI 的 Sora 终于放开了限制。

OpenAI 宣布,其备受瞩目的文生视频应用 Sora,将暂时取消邀请码要求。位于美国、加拿大、日本和韩国的用户现在无需等待,可以直接下载 iOS 应用或访问 sora.com 网站,使用 OpenAI 帐户登入体验。

这项「限时」优惠是 Sora 从封闭测试走向更广泛应用的重要一步,旨在测试服务器负载并收集更多用户回馈。如果你身处上述地区,千万别错过这个抢先体验顶级 AI 视频生成工具的机会!

Pro 用户福利:OpenAI Pulse 功能登陆网页版

除了 Sora 的好消息,OpenAI 也为其付费的 Pro 用户带来了更新。Pulse 功能现在已经可以在网页端使用,让 Pro 用户在桌面环境下也能享受到更全面的服务。

你的异步代码伙伴:Google 推出 Gemini CLI 的 Jules 扩展

Google 今天也为开发者社群带来了一份大礼,发布了 Jules——一个为 Gemini CLI 设计的扩展功能。

Jules 就像一个可以异步处理任务的「自主伙伴」。开发者可以在 Gemini CLI 中,透过简单的指令将一些耗时的任务(如修复 Bug、在新的分支中进行更改)委派给 Jules 在背景处理。这让开发者可以继续专注于当前的核心工作,而不用中断流程。你可以在 GitHub 上找到这个扩展功能。

开发者福音!Google Gemini 2.5 模型快取折扣飙升至 90%

Google 带给开发者的好消息还不止于此。根据 官方消息,Google 大幅提升了 Gemini 2.5 模型的隐式快取折扣,从原来的 75% 提高到了 90%。

这意味着,对于重复或相似的 API 请求,开发者的成本将显著降低。这项政策无疑会鼓励开发者更高效地利用模型,并降低应用开发的门槛。

安全规则自己订!OpenAI 释出 gpt-oss-safeguard 开源模型

在 AI 安全领域,OpenAI 也迈出了重要一步,发布了名为 gpt-oss-safeguard 的开源安全模型。

这系列模型(分为 120b 和 20b 两种大小)最大的特点是其灵活性。传统的安全分类器通常基于预先定义的规则,而 gpt-oss-safeguard 允许开发者在运行时提供自己的安全策略。模型会利用其推理能力来解释和应用这些自定义策略。

这种「自备策略」的设计,让开发者可以根据自身应用的特定场景(例如游戏论坛和金融应用的安全要求就截然不同)来划定安全红线,同时模型提供的「思维链」也能让开发者理解其判断依据,实现了更高的客制化和透明度。

Claude 在想什么?Anthropic 研究揭示 AI 有限的「内省能力」

今天最引人深思的新闻,或许来自 Anthropic 发布的一篇**关于大型语言模型内省能力的研究**。

你是否曾好奇,当你问 AI「你在想什么」时,它的回答是真的还是编的?Anthropic 的研究试图科学地回答这个问题。他们透过一种名为「概念注入」的实验技巧,将特定的「想法」(以神经活动模式的形式)植入到 Claude 模型中,然后观察模型是否能察觉并报告这种「外来想法」。

研究发现,像 Claude Opus 4.1 这样的顶尖模型,在某些情况下确实能够意识到被注入的概念,并报告其内部认知过程的异常。虽然这种能力目前还很不稳定(成功率约 20%),但它首次提供了科学证据,表明 AI 可能具备了某种程度的、监控和报告自身内部状态的能力。

这项发现对 AI 的透明度、可靠性乃至未来的人机互动模式,都具有极其深远的影响。虽然我们离真正理解 AI 的「内心世界」还很遥远,但这项研究无疑打开了一扇通往新世界的大门。